Reminiscencje z XXVII Konferencji Stowarzyszenia Wydawców Szkół Wyższych

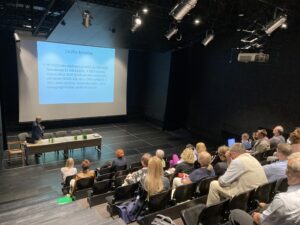

15 i 16.czerwca br. ponad 40 członków stowarzyszenia – każdy z innego ośrodka akademickiego – przyjechało do Warszawy, gdzie – w pałacowych murach Uniwersytetu Warszawskiego – dyskutowano o pilnych wyzwaniach wydawnictw naukowych. Wydawnictwo AWF Wrocław reprezentowała jego kierowniczka – Joanna Malec

Już na wstępie temperaturę spotkania podniósł temat: „Definicja autorstwa i etyka publikacyjna wobec wprowadzenia na rynek ChatGPT – rozwiązania stosowane przez międzynarodowe wydawnictwa naukowe oraz stanowisko COPE.” Temat referowała Małgorzata Adamczak z Biblioteki Uniwersyteckiej w Poznaniu.

Nie ulega wątpliwości, że korzystanie z narzędzi LLM (Large Language Models) bardzo przyśpiesza i ułatwia proces wydawniczy. Nasilające się zjawisko ostrej konkurencji co do tempa publikacji każe podejrzewać, że narzędzia te będą coraz powszechniej wykorzystywane. W rozmowach kuluarowych dało się słyszeć głosy, że świadome i rozsądne korzystnie z takich narzędzi jest uzasadnione. Jednak tematem prelekcji i dyskusji była raczej odwrotna storna medalu: precedensy (czy na pewno tylko precedensy?) używania ChatGPT do pisania tekstów naukowych i podawania ich jako własne. Tutaj pojawia się cały szereg problematycznych kwestii, jak uznanie autorstwa (autor prompta czy chat GPT?) czy popełnianie plagiatu (ChatGPT czerpie z zasobów sieci, zapożyczając je jako własne). Problemem jest też niewiarygodność informacji podawanych przez narzędzia LLM – na przykład powoływanie się na nieistniejące badania.

Jako wydawcy możemy nieświadomie przyczynić się do rozpowszechniania fałszywych badań, które – raz wprowadzone do naukowego obiegu – obrastają kolejnymi cynowaniami, powodując efekt kuli śnieżnej. Jest to nieetyczne, a w niektórych dziedzinach nauki bardzo niebezpieczne.

Czy możemy się przed tym obronić? Pytanie nie jest łatwe. Musielibyśmy – jako wydawcy – mieć pełną świadomość czy i kiedy nasz autor współpracował ze sztuczną inteligencją podczas tworzenia swojej pracy. Tymczasem na rynku nie ma skutecznych i powszechnie dostępnych detektorów. Zgodnie z informacjami podanymi na prelekcji – przy zastosowaniu współczesnych narzędzi – wykrywalność treści automatycznie generowanej nie przekracza 20 procent.

Jak postępują najwięksi wydawcy naukowi? Minimum, które możemy zrobić, to ukuć wytyczne dla autorów (i recenzentów). Czy – a jeśli tak, to na jakich warunkach – zgadzamy się na korzystanie przez autorów z narzędzi LLM. W przedstawionych przez prelegentkę przykładach dla wielu prestiżowych zagranicznych wydawców kluczowe było odnotowanie użycia narzędzia AI przez autora.

Na wniosek uczestników konferencji zaniepokojonych perspektywą niekontrolowanego wzrostu generowanych przez AI treści „naukowych”– zawiązał się zespół, który ma przygotować wzorcowe wytyczne dla członków SWSW.

Oto bardzo praktyczny wymiar pracy tego stowarzyszenia. Nastawienie na mądre działanie i otwarte dzielenie się wiedzą są znakiem jakości SWSW.

Materiał zdjęciowy dostępny dzięki uprzejmości Stowarzyszenia Wydawców Szkół Wyższych